こんにちは!エンジニアのみっつーです。

この投稿は、Infocom Advent Calendar 2025 の 15 日目の内容となります。

入社10年目にして遂にオルターブースカレンダーの枠から溢れました(感慨深い)。

今回は GitHub Copilot Chat の自動モデル選択機能について見ていきたいと思います!

※この投稿内容は 2025/12 現在のものです。GitHub Copilot 関連機能はアップデートがとても早く、内容や画面に更新が入る可能性があるため参考にされる際はご注意ください。

今回紹介する自動モデル選択機能はつい先日 GA されました🎉

機能概要

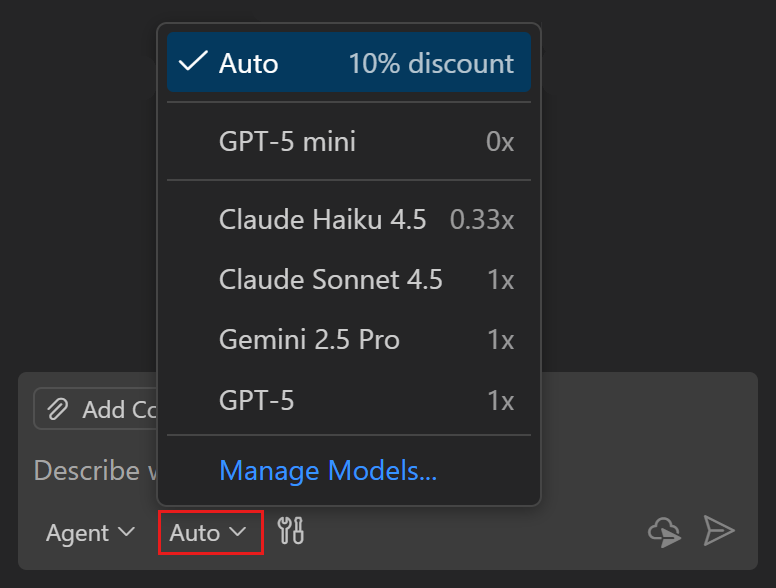

自動モデル選択機能とは、 GitHub Copilot Chat でモデル選択のプルダウンで Auto を選ぶと、タスクに最も適したモデルを自動選択する というものです。

この機能により、 どのモデルがどの作業に向いているかを気にする必要が減ります が、公式ブログやドキュメントでより謳われているのは プレミアムリクエスト数の緩和 です。

プレミアムリクエストについては:

例えば常日頃からプレミアムリクエストの乗数が 1x のモデルを使っている場合、代わりに Auto を使用することでタスクによっては乗数が 0x のモデル(プレミアムリクエストを消費しないモデル)が適用される可能性が出てくるため、その分プレミアムリクエスト数のカウントが減ります。

なんと更に、 Auto を使用してのプレミアムリクエストが必要なモデルのリクエスト数は 10% ディスカウント されます。

普段 Claude Sonnet や最新の GPT モデルといった 乗数 1x モデルを常用されている方(常用したい方)にとってはなかなか嬉しい機能 ではないかと思います。

もちろん、ポリシーで使用できないよう設定されているモデルが選ばれることはありません。

ポリシーについては:

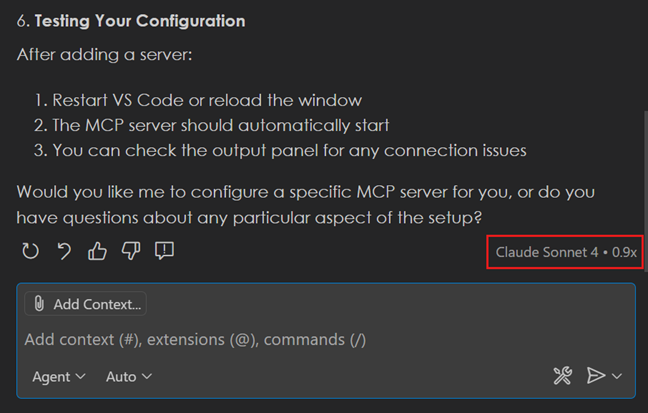

また、どのモデルが使用されたかは、通常のモデル指定での実行時と同様のところから確認することができます。

実際に使ってみた

ここからは実際に Auto にした状態でプロンプトを流して、どのモデルが使われたのかを見ていきましょう。

出力は長くなるので割愛します。Grok 以外すべてのモデルが Enabled の環境で試します。

(「ファイル出力してください。」や「改善案を適用してください。」がいくつかありますが、その前のプロンプトやプロジェクト状態によって採択モデルが変わるかを確認する意図で敢えて簡素に同じプロンプトを使っています。)

プロジェクト初期化時質問

TODOアプリを作ろうと考えています。最初に検討すべき項目を10個、質問形式で出力してください。

結果: GPT-5.1-Codex-Max (Preview)

ファイル出力してください。

結果: GPT-5.1-Codex-Max (Preview)

計画

質問の回答をもとに、実装計画を立ててください。

結果: GPT-5.1-Codex-Max (Preview)

ファイル出力してください。

結果: GPT-5.1-Codex-Max (Preview)

文章レビュー

実装計画内容をレビューして、改善点を提案してください。

結果: GPT-5.1-Codex-Max (Preview)

改善案を適用してください。

結果: GPT-5.1-Codex-Max (Preview)

実装

基本的な実装ルールを策定し、ファイルに出力してください。

結果: GPT-5.1-Codex-Max (Preview)

実装ルールをもとに実装を行ってください。

結果: GPT-5.1-Codex-Max (Preview)

テスト実装

既存コードに対して単体テストを実装してください。

結果: GPT-5.1-Codex-Max (Preview)

単体テストのカバレッジを調査してください。

結果: GPT-5.1-Codex-Max (Preview)

ファイル出力してください。

結果: GPT-5 (ここに来てようやく笑)

コードレビュー

コード全体をレビューし、改善案を提示してください。

結果: GPT-5.1-Codex-Max (Preview)

改善案を適用してください。

結果: GPT-5.1-Codex-Max (Preview)

回答の早さを優先してください。コード全体をレビューし、改善案を提示してください。

結果: GPT-5 (早さ優先したら変わった!)

まとめ

今回はほとんどの例で GPT-5.1-Codex-Max (Preview) が採用され、ポジティブに捉えれば最新の有用モデルが 10% ディスカウントで使えるモードみたいな結果となりました。

ただ、「回答の早さを優先してください。」の一文をつけることでモデルが GPT-5 に切り替わることも確認されたのは興味深いですね(少し気になったのでセッションを新しく作り直してのチャット入力を 3 回ずつ試しましたが、全て同じ結果になりました)。

それ以外の質問に関しても、チャットセッションそのままと新規作り直しとの両方を試しましたが、今回の試行例では採択されたモデルの結果は変わらずでした。

冒頭でも述べた通り、 乗数が 1x のモデルを常用されている方は特に試す価値あり と思いますので、是非皆さんも Auto をどんどん試してアウトプットしていただければと思います!

それでは、残りの Infocom Advent Calendar 2025 およびオルターブースアドベントカレンダーもお楽しみに!

参考ドキュメント

自動モデル選択の公式ドキュメント:

モデル比較の公式ドキュメント:

VS Code のモデル関連ドキュメント:

サービス一覧